Install Video Subtitle Master (CUDA 11.8 Optimized) using Winget - wingetCollections

Go back Packages Video Subtitle Master (CUDA 11.8 Optimized) Video Subtitle Master (CUDA 11.8 Optimized) buxuku Use this command to install Video Subtitle Master (CUDA 11.8 Optimized):

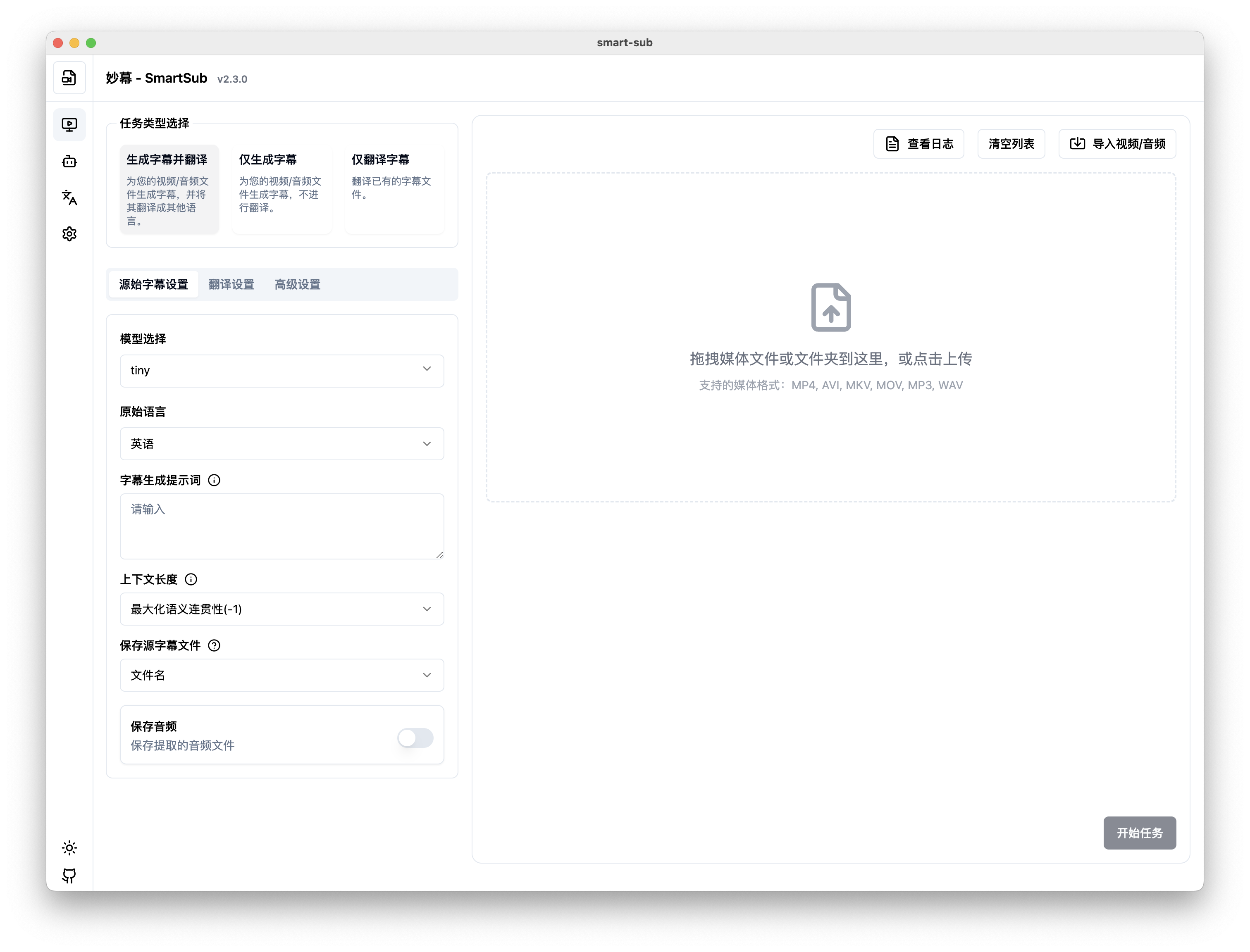

winget install --id=buxuku.SmartSub.CUDA.11.8.Optimized -e Copy WinGet command to clipboard Video Subtitle Master is a desktop application designed to batch generate subtitles for videos and audio files and translate them into multiple languages. Built as an enhanced version of VideoSubtitleGenerator, it offers a user-friendly interface while retaining all core functionalities.

Key Features:

Batch subtitle generation from video or audio files

Multi-language translation support using services like Volcano Engine, Baidu, DeepLX, Ollama, and OpenAI-style APIs

Hardware acceleration via NVIDIA CUDA (Windows/Linux) and Apple Core ML (macOS)

Customizable subtitle naming for compatibility with various media players

Option to generate pure translations or original + translated subtitles

Local installation of whisper command support

Configurable concurrent task limits

Ideal for content creators, educators, and professionals who need efficient multilingual subtitle creation. Streamline workflows and enhance accessibility for global audiences while maintaining data privacy through local processing. Install via winget for easy setup.

README 2.11.1

Copy WinGet command to clipboard 2.11.0

Copy WinGet command to clipboard 2.10.2

Copy WinGet command to clipboard 2.10.1

Copy WinGet command to clipboard 2.9.0

Copy WinGet command to clipboard 2.8.1

Copy WinGet command to clipboard 2.8.0

Copy WinGet command to clipboard 2.7.0

Copy WinGet command to clipboard 2.6.0

Copy WinGet command to clipboard 2.5.2

Copy WinGet command to clipboard Download Video Subtitle Master (CUDA 11.8 Optimized)

💥特性

支持多种视频/音频格式生成字幕

支持对生成的字幕,或者导入的字幕进行翻译

本地化处理,无须上传视频,保护隐私的同时也拥有更快的处理速度

支持多种翻译服务:

火山引擎翻译

百度翻译

微软翻译器

DeepLX 翻译 (批量翻译容易存在被限流的情况)

本地模型 Ollama 翻译

AI聚合平台 DeerAPI

支持 OpenAI 风格 API 翻译,如 deepseek , azure 等

🎯 自定义参数配置 : 无需代码修改,直接在界面配置 AI 模型参数 v2.5.3-release-brief.md

支持自定义请求头和请求体参数

支持多种参数类型(文本、数字、开关、JSON对象等)

实时参数验证和错误提示

参数配置导出导入功能

自定义字幕文件名,方便兼容不同的播放器挂载字幕识别

自定义翻译后的字幕文件内容,支持纯翻译结果或原字幕+翻译结果

支持硬件加速

NVIDIA CUDA(Windows/Linux)

Apple Core ML(macOS M系列芯片)

支持运行本地安装的 whisper 命令

支持自定义并发任务数量

关于 CUDA 的支持 因为本人使用的是苹果芯片,缺少 window CUDA 的开发环境,对于 CUDA 的支持,开发测试都存在较多场景无法兼顾的情况。

目前提供了 CUDA 11.8.0 和 12.2.0 及 12.4.0 版本的编译,是通过 github action 自动编译的,可能存在环境的兼容问题

要启用 CUDA,需要确定自己的电脑支持 CUDA, 并安装了 CUDA toolkit. CUDA download

CUDA toolkit 的版本理论上是向后兼容,请根据你显卡支持的版本,选择合适的版本

如果下载 generic 使用有问题,可以下载 optimized 版本,这个版本是针对各个系列显卡的优化版本,兼容性更强

关于 Core ML 的支持 从 1.20.0 版本开始,在苹果芯片上,支持使用 Core ML 加速语音识别。如果是苹果芯片,请下载 mac arm64 版本的 release 包。将会自动启动 Core ML 加速。

翻译服务 本项目支持多种翻译服务,包括百度翻译、火山引擎翻译、DeepLX、Ollama 本地模型、 DeepSeek 以及 OpenAI 风格的 API。使用这些服务需要相应的 API 密钥或配置。

对于 AI 翻译,翻译结果受模型和提示词的影响比较大,你可以尝试不同的模型和提示词,找到适合自己的组合。推荐可以尝试 AI 聚合平台 DeerAPI , 支持多个平台近 500 种模型,选择合适自己的模型进行翻译。

自定义参数配置 (v2.5.3) SmartSub 现在支持为每个 AI 翻译服务配置自定义参数,让您能够精确控制模型行为:

灵活参数配置 : 直接在界面添加和管理自定义参数,无需修改代码参数类型支持 : String、Float、Boolean、Array、Object、Integer 参数类型实时验证 : 参数修改时实时验证,防止无效配置配置管理 : 支持导出导入配置,方便团队共享和备份自动保存 :沿用系统设计,自动保存任何修改

模型的选择 从视频或者音频里面,生成字幕文件,需要使用到 whisper 的模型。 whisper 的模型有多种,不同的模型,生成字幕的准确性不同,处理速度也不同。

模型越大,准确性越高,对显卡要求也高,处理速度越慢

低端设备或者显卡,推荐 tiny 或者 base 系列的模型,准确性虽然不如 large 系列,但是处理速度快,占用显存小

普通电脑设备,建议从 small 或者 base 开始,平衡精度与资源消耗

对于高性能显卡/工作站,推荐使用 large 系列的模型,准确性高

如果原始音视频是英文,推荐使用带 en 的模型,专为英语优化,减少多语言干扰

如果在乎模型大小,可以考虑使用 q5 或者 q8 系列的模型,相对于非量化版本,牺牲少量精度换取更小体积

🔦使用 (普通用户) 请根据自己的电脑系统,芯片,显卡,选择下载对应安装包。

带 generic 的版本,是通用的版本,理论上支持常见的显卡

带 optimized 的版本,是优化版本,提供了针对各个系列显卡的优化,兼容性更强

系统 芯片 显卡 下载安装包 Windows x64 CUDA >= 11.8.0 < 12.0.0 windows-x64_cuda11.8.0 Windows x64 CUDA >= 12.4.0 windows-x64_cuda12.4.0 Windows x64 CUDA >= 12.2.0 windows-x64_cuda12.2.0 Windows x64 无 CUDA windows-x64_no_cuda Mac Apple 支持 CoreML mac-arm64 Mac Intel 不支持 CoreML mac-x64 Linux x64 CUDA >= 13.0.2 linux-x64_cuda13.0.2 Linux x64 CUDA >= 12.4.0 linux-x64_cuda12.4.0 Linux x64 无 CUDA linux-x64_no_cuda

macOS 用户通过 Homebrew 安装)(推荐) macOS 用户可以通过 Homebrew 快速安装,会自动根据芯片类型(Intel/Apple Silicon)下载对应版本:

# 添加 tap(只需执行一次)

brew tap buxuku/tap

# 安装

brew install --cask smartsub

# 升级到最新版本

brew upgrade --cask smartsub

# 卸载

brew uninstall --cask smartsub

手动下载安装

前往 release 页面根据自己的操作系统下载安装包

或者使用网盘 夸克 选择对应的版本进行下载

安装并运行程序

下载模型

在程序中配置所需的翻译服务

选择要处理的音视频文件或字幕文件

设置相关参数(如源语言、目标语言、模型等)

开始处理任务

🔦使用 (开发用户) git clone https://github.com/buxuku/SmartSub.git

2️⃣ 在项目中执行 yarn install 或者 npm install

3️⃣ 依赖包安装好之后,执行 yarn dev 或者 npm run dev 启动项目

手动下载和导入模型 因为模型文件比较大,如果通过该软件下载模型会存在难以下载的情况,可以手动下载模型并导入到应用中。以下是两个可用于下载模型的链接:

如果是苹果芯片,需要同时下载模型对应的 encoder.mlmodelc 文件。并解压出来放在模型相同目录下。(如果是 q5 或者 q8 系列的模型,无须下载该文件)

下载完成后,您可以通过应用的"模型管理"页面中的"导入模型"功能将下载的模型文件导入到应用中。或者直接复制到模型目录里面即可。

在"模型管理"页面中,点击"导入模型"按钮。

在弹出的文件选择器中,选择您下载的模型文件。

确认导入后,模型将被添加到您的已安装模型列表中。

常见问题

1.提示应用程序已损坏,无法打开。 sudo xattr -dr com.apple.quarantine /Applications/SmartSub.app

贡献 👏🏻 欢迎提交 Issue 和 Pull Request 来帮助改进这个项目!

支持 ⭐ 如果您觉得这个项目对您有帮助,欢迎给我一个 star,或者请我喝一杯咖啡(请备注你的 github 账号)。

👨👨👦👦 如果您有任何使用问题,欢迎加入微信交流群,一起交流学习。

许可证

Star History